Wan 2.1 评测 2026:我测试了它,确实感觉可用

- 1. 我认为 Wan 2.1 的优点(以及为什么重要)

- 2. Wan 2.1 评测:Wan 2.1 实际是什么

- 3. 模型阵容和结构(节省你数小时的部分)

- 4. 实际改变结果的关键功能

- 5. 入门(我推荐的步骤)

- 6. 性能和基准(数字的实际意义)

- 7. 实际用例(Wan 2.1 的闪光点)

- 8. 挑战和局限性(我希望更多评测承认的内容)

- 9. Wan 2.1 与替代方案(我如何公平比较)

- 10. 优缺点(我诚实的总结)

- 11. 常见问题(我每周都会看到的问题)

- 12. 结论:Wan 2.1 是"你实际可以用来交付的开源视频"

Wan 2.1 评测可以简单总结为:它是首批感觉"实用"的开源视频生成器之一,而不仅仅是"在演示中令人印象深刻",特别是如果你关心本地运行和快速迭代。我是从构建可重复视频工作流的角度来写这篇文章的——而不仅仅是一次性的电影片段——所以我会专注于结构、实际功能,以及真正改变你日常结果的内容。

1. 我认为 Wan 2.1 的优点(以及为什么重要)

Wan 2.1 值得关注,因为它将开源视频生成变成了一个你可以实际运行、调整和重新运行的工作流,而不会感到迷失。

以下是为什么这对我重要的简短版本:

- 本地控制:我可以保持实验的一致性(相同的提示风格,相同的设置逻辑),避免"云端情绪波动"。

- 清晰的模型阵容:有一个轻量级轨道和一个质量轨道,命名大致合理。

- 真正的生产循环:生成 → 选择最佳结果 → 通过受控更改迭代。

如果你尝试过旧的开源视频堆栈,你会知道常见的失败模式:你花费 80% 的时间在设置、内存和不稳定的运动上挣扎。Wan 2.1 并没有神奇地解决视频生成问题,但它确实让循环感觉不那么脆弱。

2. Wan 2.1 评测:Wan 2.1 实际是什么

一句话总结 Wan 2.1 评测:它是一个开源的文本到视频(Text-to-Video)和图像到视频(Image-to-Video)模型家族,设计用于在消费级 GPU 上运行,提供一个轻量级选项以扩大访问范围,以及一个更大的选项以提高质量。

官方仓库将 Wan 2.1 定位为"运行文本到视频生成",具有两个主要的 T2V 模型尺寸(1.3B 和 14B)和两个目标分辨率(480p 和 720p)。1.3B 模型被定位为"几乎任何消费级 GPU"选项,而 14B 系列则是以质量为中心的路线。(你还会在模型中心和社区工作流中看到 I2V 变体。)

一个在实践中保持真实的快速心智模型:

- 1.3B = 更容易运行,更快的实验,非常适合测试提示想法。

- 14B = 更重,更好的细节/一致性,更适合"接近最终"的输出。

- 480p vs 720p = 稳定性和速度 vs 清晰度和细节。

如果你正在浏览 Wan 系列页面,将 Wan 2.1 视为"基础生成集"是有帮助的,然后稍后查看 Wan 2.2 和 Wan 2.6,了解该系列如何演变。

3. 模型阵容和结构(节省你数小时的部分)

Wan 2.1 的结构对于一个开源视频项目来说异常容易理解。

从高层次来看,你会遇到两个实用轨道:

- 文本到视频(T2V)

- T2V-1.3B(通常为 480p)

- T2V-14B(480p + 720p 配置)

- 图像到视频(I2V)

- 14B I2V 变体通常出现在 480p 和 720p 的社区工作流和模型中心。

我喜欢这种设置的原因是它支持一个干净的"生产阶梯":

- 草稿阶段(便宜,快速):1.3B @ 480p 以验证想法。

- 升级阶段(质量提升):14B @ 720p 以完善运动和细节。

- 包装阶段(分发):在你常用的管道中裁剪/扩展/编辑。

这个阶梯比人们想象的更重要:最快的浪费时间方式就是试图从第一次生成就强求"最终质量"。

4. 实际改变结果的关键功能

Wan 2.1 之所以特别,是因为它的功能集与创作者和构建者反复执行的操作保持一致:控制运动、保持连贯性,并且不会爆炸你的硬件需求。

以下是我工作流中最重要的功能,以及它们的实际意义。

4.1 多模态生成(T2V 和 I2V)

Wan 2.1 的多模态阵容很有用,因为它提供了两种不同的控制风格:基于提示的创作和基于参考的创作。

- 文本到视频 最适合探索概念和故事方向。

- 图像到视频 最适合当你已经有一个外观(角色/产品)并需要运动时。

在实践中,我将 I2V 视为"品牌一致性"模式。如果你来自 图像到视频 工作流思维,Wan 2.1 的 I2V 系列会感觉很熟悉:你从一个强大的帧开始,并将你的提示集中在运动和相机上。

4.2 高分辨率输出(带有现实预期)

Wan 2.1 在 480p/720p 工作流中表现强劲,当你接受这作为默认值时,它是最可靠的。

一些评测提到通过某些 14B 配置或上采样路径实现 1080p 的能力,但我使用的实际结论更简单:从稳定开始,然后上采样,而不是反过来。如果你从高分辨率开始并与不稳定性作斗争,你最终会在时间和 GPU 痛苦上"付出双倍代价"。

4.3 在消费级硬件上的高效性

Wan 2.1 值得称赞,因为它的设计是可以在没有数据中心的情况下运行的。

轻量级的 1.3B 模型专门定位于广泛的 GPU 兼容性,多个指南将该堆栈描述为"消费级 GPU 友好",并具有精度选择(fp16/fp8),在质量和可行性之间进行权衡。如果你尝试运行其他开源视频模型并立即遇到 VRAM 墙,你会欣赏到 Wan 2.1 拥有一个真正的"入门门槛",而不仅仅是一句营销语。

4.4 强调视频连贯性的架构选择

Wan 2.1 的架构重点表现为当运动开始时更少的"随机崩溃"。

我并不是说它是完美的——开源视频仍然是开源视频——但设计故事(用于视频潜在变量的 VAE + 用于扩散的变压器骨干)与输出中看到的内容相匹配:运动通常更易读,场景在相机移动时不太可能融化。

4.5 精细的提示控制(我实际如何写提示)

Wan 2.1 在你像导演而不是诗人一样写提示时表现更好。

以下是我反复使用的提示结构:

- 主体锚点:谁/什么不能改变

- 动作:一个主要的运动想法(而不是五个)

- 相机:一个相机行为(静止/缓慢推入/平移)

- 风格:一个风格层(电影感、动漫、纪录片等)

- 约束:"无变形"、"无多余肢体"、"背景稳定"等

一个快速示例格式(不是魔法咒语——只是一个稳定的模板):

- 主体:"一个小机器人厨师"

- 动作:"搅拌汤,蒸汽升起"

- 相机:"缓慢推入"

- 风格:"温暖的厨房灯光,电影感"

- 约束:"保持角色一致,无闪烁,手部稳定"

原因很无聊但真实:模型有更少的机会自相矛盾。

4.6 声音同步支持(将其视为奖励,而非保证)

Wan 2.1 的声音同步角度令人兴奋,因为开源视频很少尝试讨论音频对齐。

不过,我将声音同步视为"辅助",而不是编辑替代。如果你的项目需要紧密的唇同步或节拍精准的剪辑,你仍然需要一个后期工作流。但作为一个创意起点——尤其是短片——内置的声音感知生成是一个有意义的进步。

4.7 开源优势(隐藏的功能)

Wan 2.1 是开源的,这是一项功能,因为它改变了你可以围绕它构建的内容。

对于构建者和团队来说,开源权重 + 可运行推理意味着:

- 可重复的管道,

- 近似确定性的设置记录,

- 能够集成到你自己的工具中,

- 以及快速改进的社区工作流。

如果你正在发布实验,记录你的设置成为你"EEAT"故事的一部分:你不仅仅是在说它好——你在展示你是如何获得结果的。

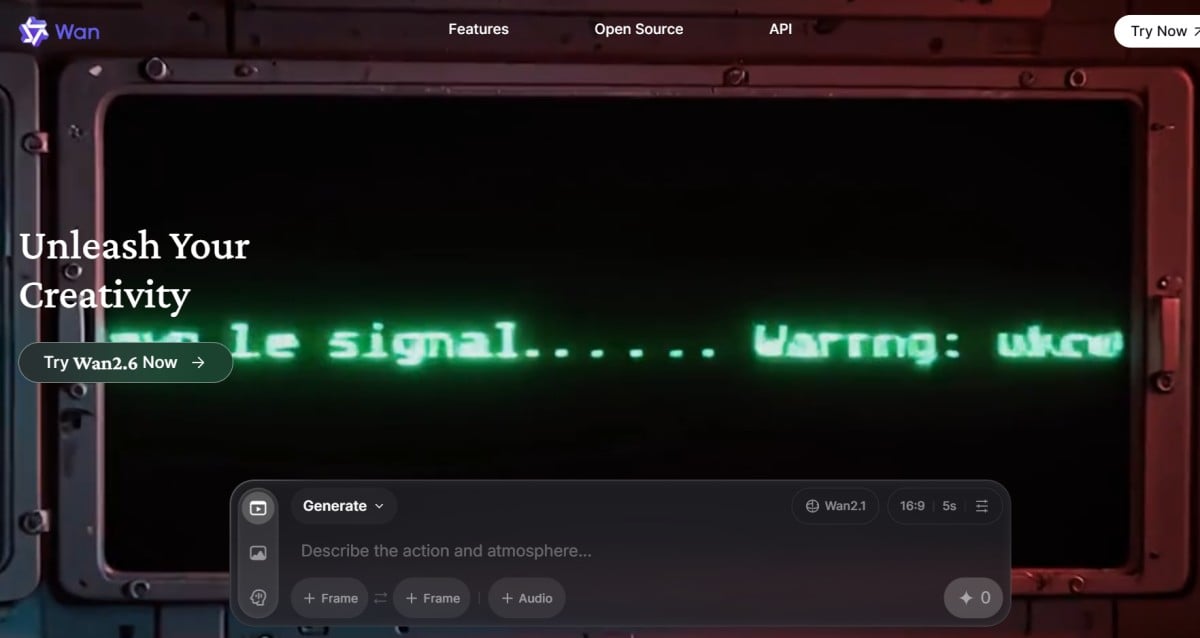

5. 入门(我推荐的步骤)

Wan 2.1 最简单的方法是选择一条路径并坚持一天,而不是在五个安装之间跳来跳去。

以下是我看到大多数人成功的两个实际路线:

5.1 路线 A:官方仓库/脚本工作流

如果你想要可重复性和更少的 UI 变量,这条路线是最好的。

- 克隆官方仓库并按照环境设置。

- 从 T2V-1.3B @ 480p 开始,确认一切运行正常。

- 像保存代码一样保存配置:保留一个"已知良好"预设。

- 然后再移动到 14B / 720p。

参考(外部,nofollow):

5.2 路线 B:使用 ComfyUI 工作流更快迭代

如果你想要速度、视觉控制和轻松的变化,这条路线是最好的。

- 加载一个经过验证的社区工作流(不要从头开始)。

- 用一个短生成进行验证。

- 构建你自己的"变化旋钮"(种子、提示块、相机块、运动块)。

参考(外部,nofollow):

5.3 我的"不要浪费一天"清单

当你提前做出一些有纪律的选择时,Wan 2.1 会更顺利。

- 先使用简短提示,然后在运动稳定后添加细节。

- 每个剪辑保持一个运动想法。

- 优先 480p 草稿,然后升级。

- 像实验一样记录种子 + 提示 + 分辨率 + 步骤。

6. 性能和基准(数字的实际意义)

Wan 2.1 的性能故事对于开源来说不错,但你应该将基准视为"规划信号",而不是承诺。

一个常被引用的运行时示例是,在 RTX 3090(24GB VRAM)上,Wan 2.1 每分钟处理时间大约可以生成 15 秒的视频。这是一个用于调度和预算的有用参考点,但实际速度在很大程度上取决于精度、步骤、分辨率和工作流开销。

以下是我如何将基准谈话转化为决策:

- 如果我在探索想法:优化迭代(较低分辨率,较少步骤)。

- 如果我在打磨:优化清晰度(较高分辨率,更多步骤,更好的提示约束)。

- 如果我需要多个输出:批量变化,进行小的受控更改。

快速规划表(实用,而非科学)

| 目标 | 模型 | 分辨率 | 为什么这个组合有效 |

|---|---|---|---|

| 快速测试 10 个概念 | 1.3B | 480p | 草稿更便宜,失败更快 |

| 构建一致的风格包 | 14B | 720p | 更好的细节和连贯性 |

| 锁定运动,然后上采样 | 14B | 480p → 720p | 先稳定,再追求质量 |

| 从图像原型化角色 | I2V 14B | 480p | 参考保持身份更稳定 |

7. 实际用例(Wan 2.1 的闪光点)

当你将 Wan 2.1 视为构建块生成器而不是完整电影机器时,它表现最佳。

以下是我一直看到开源视频模型(包括 Wan 2.1)提供实际价值的用例:

-

创意内容生成(短视频)

- 5–10 秒的简短剪辑,用于 Reels/短视频

- 可循环的运动时刻(行走循环、反应、简单动作)

-

营销原型

- 在投入完整制作之前的概念广告

- 场景中的产品草稿(特别是通过 I2V)

-

分镜和预可视化

- "用于节奏验证的基本运动质量"

- 在最终拍摄/动画之前测试相机运动

-

风格探索

- 一个概念,多种美学

- 使用一致运动进行受控 A/B 测试

如果你想要一个简单的"一个地方了解整个系列",Wan AI 概览页面是一个有用的内部中心——然后在你缩小目标时分支到特定版本页面。

8. 挑战和局限性(我希望更多评测承认的内容)

Wan 2.1 很强大,但开源视频仍然需要耐心和纪律。

以下是我计划的局限性:

-

长剪辑的稳定性仍然很难

即使是强大的模型也可能随着时间推移而漂移;计划拼接短剪辑,而不是强迫长剪辑。 -

过多的提示堆叠弊大于利

如果你堆叠太多风格形容词和动作,运动连贯性通常会受损。 -

硬件限制是真实的

14B 模型可能很苛刻;最好的解决方案是草稿 → 升级管道,而不是蛮力。 -

偶尔的伪影和闪烁

你仍然会看到闪烁、变形的手或背景抖动;建立一个后期步骤(去噪、稳定化、编辑剪辑)。 -

社区工作流差异

两个"Wan 2.1 工作流"可能因节点、调度器和默认值而表现截然不同——记录你的设置。

9. Wan 2.1 与替代方案(我如何公平比较)

当你将 Wan 2.1 与其他开源选项和你无法自定义的云工具进行比较时,它的竞争力最佳。

我从四个标准进行比较:

- 本地运行的可行性(我能实际运行它吗?)

- 运动连贯性(它能保持一致吗?)

- 控制(提示 + 设置是否表现得可预测?)

- 工作流生态系统(是否有稳定的指南/工作流?)

比较表(以创作者为中心)

| 模型/选项 | 优势 | 弱点 | 最适合 |

|---|---|---|---|

| Wan 2.1 | 可运行的开源管道 + 良好的连贯性 | 仍需调整 | 构建者 + 可重复的生产循环 |

| 专有云模型 | 速度 + 抛光输出 | 控制/可见性较少 | 一次性营销镜头 |

| 其他开源视频堆栈 | 灵活的实验 | 设置摩擦 | 研究 + 小众工作流 |

如果你专门跟踪 Wan 系列,将 Wan 2.1 与 Wan 2.2 进行比较有助于你了解新一代改进的内容(尤其是围绕 I2V 的重点),而 Wan 2.6 通常是你在学习基础知识后寻找"最新旋钮"的地方。

10. 优缺点(我诚实的总结)

Wan 2.1 是一个强大的开源选择,如果你更想要控制和可重复性,而不是即时完美。

优点

- 清晰的模型阶梯(1.3B 草稿 → 14B 质量)

- 本地友好的定位(尤其是 1.3B)

- 在其类别中具有坚实的运动连贯性

- 开放生态系统:工作流改进迅速

缺点

- 仍然比云工具更慢且更需要动手

- 高端质量可能对硬件要求较高

- 长剪辑漂移;短剪辑 + 拼接效果更好

- 提示和设置需要纪律

11. 常见问题(我每周都会看到的问题)

Wan 2.1 用"是的,如果你将它视为一个管道"回答了大多数"这是否可用?"的问题。

问:我应该从 14B 开始以获得最佳结果吗?

不——从 1.3B 开始以锁定你的工作流,然后在你知道设置稳定后升级。

问:720p 总是比 480p 更好吗?

如果你的运动不稳定,那就不是。我宁愿有一个稳定的 480p 草稿,而不是一个摇晃的 720p 剪辑。

问:我可以将它用于专业工作吗?

是的,用于原型、概念化和短视频内容,但你应该期望一个后期工作流来进行抛光。

问:提高输出质量最快的方法是什么?

选择一个运动想法,简化提示,并通过受控更改(种子/步骤/分辨率)迭代,而不是重写所有内容。

官方参考(外部,nofollow):

12. 结论:Wan 2.1 是"你实际可以用来交付的开源视频"

Wan 2.1 评测的结尾回到了开头:它不是那个神奇地消除所有视频生成问题的模型,但它确实是首批感觉你可以围绕它构建一个可重复工作流的开源堆栈之一。如果你以一个有纪律的阶梯方法接近它——快速草稿,稍后升级,并将提示视为指导——Wan 2.1 不再是一个科学项目,而是一个你每周都可以使用的实用工具。