Kling 2.6 Motion Control Review: Der vollständige Leitfaden für Creator

- 1. Einführung: Der doppelte Durchbruch der KI-Videoerzeugung

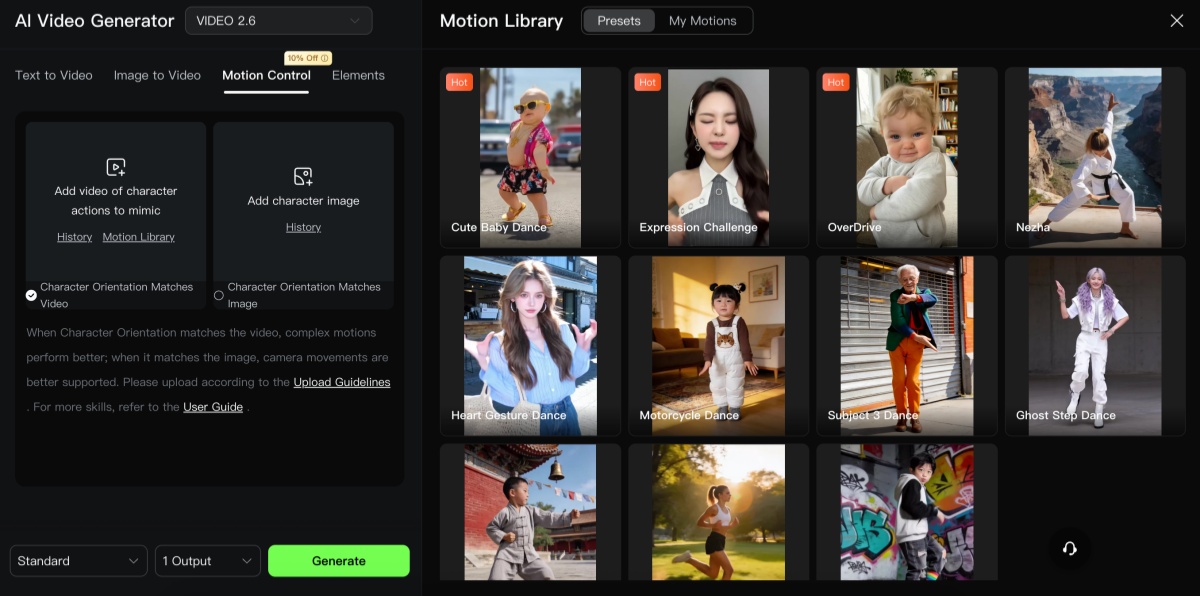

- 2. Was ist Kling 2.6 Motion Control AI?

- 3. Kernfähigkeiten der Bewegungssteuerung: Mehr als Text-Prompts

- 4. Audio-visuelle Synthese mit einem Klick

- 5. Versionsvergleich: 2.6 vs 2.5 Turbo vs Kling O1

- 6. Beherrschung von Motion Tokens: Die Steuerungssprache

- 7. Fehlerbehebung: Warum KI die falschen Teile bewegt

- 8. Motion Control Starter Kit: 10 sofort nutzbare Prompts

- 9. Praxisanwendungen: Wer bereits profitiert

- 10. Benutzerhandbuch: Maximierung Ihrer Ergebnisse

- 11. Preis- & ROI-Analyse

- 12. FAQ: Alles, was Sie wissen müssen

- 13. Fazit & Einstieg — Zusammenfassung

Nach Tests mehrerer KI-Video-Tools in realen Projekten trat immer wieder dasselbe Problem auf: Die Bewegung sah gut aus, fehlte jedoch an Konsistenz, und Audio wurde stets zu einem separaten, zeitaufwändigen Schritt. Kling 2.6 Motion Control stach hervor, weil es Bewegung als steuerbares Asset behandelt und synchronisierte Audiospuren im selben Durchgang erzeugt – etwas, das den Workflow für Kurzvideo-Ersteller grundlegend verändert.

1. Einführung: Der doppelte Durchbruch der KI-Videoerzeugung

Kling Motion Control löst zwei der schmerzhaftesten Engpässe in der Kurzvideo-Produktion – unzuverlässige Bewegung und getrennte Audio-Workflows – durch die Kombination von referenzgesteuerter Bewegungssteuerung mit nativer Audioerzeugung.

Aus praktischen Tests und Projekterfahrungen verkürzt diese Kombination die Iterationszyklen und liefert nutzbare, veröffentlichungsfertige Clips deutlich schneller als der ältere „Video zuerst, Audio später"-Ansatz.

Warum das wichtig ist:

- Oberste Ebene: Wiederholbare Performance mit synchronisiertem Ton aus einem einzigen Job liefern.

- Mittlere Ebene: Weniger Bedarf an Motion Capture, manueller Keyframe-Animation und separaten Sounddesign-Durchläufen.

- Basis: Tage an Schnittzeit sparen und Produktionsbudgets für Social- und Prototyp-Inhalte senken.

2. Was ist Kling 2.6 Motion Control AI?

Kling 2.6 ist ein referenzgesteuertes Bild-zu-Video-System, das Bewegung aus einem Quellclip auf ein Zielbild überträgt und dabei Identität und Stil schützt.

Praktisch bedeutet das: Das Modell verarbeitet ein Standbild (oder den ersten Frame) plus eine Bewegungsreferenz, extrahiert Skelett- und Zeitinformationen und rendert ein Subjekt, das diese Bewegung ausführt – ein Workflow, der sich eher wie Puppenspiel als Raten anfühlt.

Technische Struktur:

- Oberste Ebene: Motion Encoder liest die Referenz und erzeugt Pose-/Flow-Daten Frame für Frame.

- Mittlere Ebene: Ein Renderer überträgt die Bewegung auf das Zielsubjekt und gewährleistet Gesichts- und Stil-Konsistenz.

- Basis: Nachbearbeitungsschritte umfassen zeitliche Glättung, Hand-/Gesichtsverfeinerung und optionale Audioausrichtung, um einen einzigen zusammenhängenden Clip zu erzeugen.

3. Kernfähigkeiten der Bewegungssteuerung: Mehr als Text-Prompts

Kling 2.6 agiert als präzise Bewegungsübertragungsmaschine statt als kreativer Rater; dieser Wandel verändert, wie Prompts formuliert und Assets vorbereitet werden.

Wo früher komplexe Choreografien textlich beschrieben werden mussten, liefert die Bewegungsreferenz nun die Bewegung, und der Prompt definiert Szene, Kostüm und Stimmung.

Hauptstärken

- Ganzkörper-Bewegungsübertragung: Framegenaue Posen-Replikation für Tanz, Stunts und Choreografie.

- Komplexe Bewegungssteuerung: Funktioniert bei dynamischen Aktionen (Skaten, Kampfsport), wenn Referenzen sauber und gut gerahmt sind.

- Feinsteuerung: Nahaufnahmen von Hand-/Fingerbewegungen und Mikroexpressionen verbessern sich mit dedizierten Durchläufen.

- Duale Orientierungsmodi: Wahl zwischen charakterzentrierter Bewegung oder kameragesteuerten Trajektorien.

- Neudefinition der Prompt-Rolle: Text dient primär zur Festlegung von Umgebung, Kleidung und Beleuchtung, nicht zur Beschreibung jeder Gliedmaßenbewegung.

4. Audio-visuelle Synthese mit einem Klick

Kling 2.6 integriert native Audioelemente – Stimme, Effekte und Ambiente – im selben Generierungsdurchgang, was die Produktionsrechnung grundlegend verändert: Ein einzelner Render kann nun nahezu postproduktionsfertig sein.

Tests mit kurzen Werbestücken und Dialogausschnitten zeigten, dass integriertes Audio Übergaben reduziert und A/B-Tests kreativer Varianten im Vergleich zu separater Audioarbeit trivial macht.

Wertsteigerung durch Integration:

- Oberste Ebene: Ein 5–15 Sekunden Clip kann mit synchronisiertem Dialog und reaktiven Effekten direkt geliefert werden.

- Mittlere Ebene: Sprachgenerierung unterstützt mehrere Sprachen und stimmt Phoneme auf Mundbewegungen ab, während Effekte der Bewegungsintensität (Fußschritte, Aufprälle) angepasst werden.

- Basis: Ambienteschichten werden automatisch hinzugefügt, um die Szene zu verorten und Glaubwürdigkeit zu erhöhen.

5. Versionsvergleich: 2.6 vs 2.5 Turbo vs Kling O1

Kling 2.6 ist die pragmatische Wahl für Bewegungsgenauigkeit und Audio-Synchronisation; Kling 2.5 Turbo fokussierte sich auf Prompt-Treue und dynamische Kamerabewegungen; Kling O1 zielt auf eine einheitliche multimodale Plattform für Multi-Shot-Workflows ab.

Der Vergleich dieser Optionen half bei der Entscheidung, welches Modell für welche Aufgaben genutzt wird: 2.6 für wiederholbare, performanceorientierte Outputs, 2.5 für schnelle kreative Prototypen und O1 für schnittorientierte oder Multi-Shot-Kontinuität.

Vergleichshighlights

- Bewegungspräzision: 2.6 führt, wenn eine reale Referenz die finale Bewegung beeinflusst.

- Kreative Entdeckung: 2.5 Turbo bleibt schneller für explorative Visuals und dramatische Kamerasprachen.

- Einheitliche Pipelines: O1 ist ideal für Multi-Shot-Projekte mit konsistenter Bearbeitung und Kontinuität.

6. Beherrschung von Motion Tokens: Die Steuerungssprache

Motion Tokens fungieren als deterministisches Kürzel für Gliedmaßen, Kameras und Mikroexpressionen; deren Beherrschung erhöht die Vorhersagbarkeit der Ergebnisse erheblich.

Wenn Tokens nach einer sauberen Referenz geschichtet werden, werden Outputs kontrollierbar – ähnlich traditionellen Animationspipelines, jedoch mit deutlich weniger manuellem Aufwand.

Token-Taxonomie

- Gliedmaßentokens: Fixieren oder justieren Gliedmaßen für Produktinteraktionen oder Choreografieanpassungen.

- Kameratokens: Dolly-, Schwenk- und Rotationsbefehle für filmische Bewegungen.

- Mikrotokens: Blinzeln, Atmen und kleine Gesichtssignale, die Charaktere lebendig wirken lassen.

Praktischer Workflow

- Breite Posen mit Gliedmaßentokens fixieren.

- Kamerasprache hinzufügen, um Bewegungsbeziehungen zu schaffen.

- Mit Mikrotokens abschließen, um Realismus in Nahaufnahmen zu erzeugen.

7. Fehlerbehebung: Warum KI die falschen Teile bewegt

Bewegungsabweichungen lassen sich fast immer auf problematische Referenzen, widersprüchliche Anweisungen oder Größenunterschiede zurückführen; die Behebung dieser drei Elemente löst die meisten Probleme.

Ein disziplinierter Ansatz bei Aufnahme und Prompt-Design verhindert unnötige Iterationen und schont Rechenkapazitäten.

Wichtige Fehlerquellen und Lösungen

- Verschwommene oder verdeckte Referenzen: Neuaufnahme mit höherer Verschlusszeit und saubererem Bildausschnitt.

- Skalen-/Verhältnisabweichung: Zuschneiden oder Referenz wählen, die dem Ziel proportional näherkommt.

- Widersprüchliche Sprache: Vermeiden, eine statische Pose zu verlangen und gleichzeitig einen dynamischen Bewegungsclip anzuhängen.

Fünf Auswahlregeln

- Einzelbild-Referenzclips ohne Schnitte verwenden.

- Kamerawinkel und Subjektposition an das Ziel anpassen.

- Einfache Hintergründe oder kontrollierte Chroma-Pässe bevorzugen.

- Separate Hand-/Gesichtsaufnahmen für Mikrodetaillierung erfassen.

- Beleuchtung konsistent zum angestrebten Endlook halten.

8. Motion Control Starter Kit: 10 sofort nutzbare Prompts

Eine prägnante Prompt-Bibliothek ermöglichte schnelle Iterationen in Tests; diese Vorlagen wurden anhand realer Jobs verfeinert und können mit geringfügigen Anpassungen in Dauer oder Tokens direkt in die UI übernommen werden.

Repräsentative Vorlagen (nur Englisch)

- Dance transfer:

Apply motion from ref_dance.mp4 to subject.png; preserve identity; output 10s @24fps. - Product hand pass:

Use ref_hand_demo.mp4 to show a product pass; keep camera dollied left-to-right; highlight product at 00:03. - Sports slow-motion:

Map jump peak from ref_jump.mp4; emphasize frame 0.6s; add impact SFX.

Wie man iteriert

- Konservativ starten: kurze Dauer, wenige Tokens, dann Details erhöhen, sobald die Grundbewegung stimmt.

9. Praxisanwendungen: Wer bereits profitiert

Frühe Anwender – Kurzvideo-Ersteller, Marken-Teams und Indie-Filmemacher – schätzen die Kombination aus Bewegungsgenauigkeit und nativer Audiointegration besonders für schnelle Durchlaufzeiten.

Fallstudien zeigen reduzierte Nachdrehtage und schnellere Lokalisierungszyklen bei Werbungen, wenn Bewegungssteuerung zur Standardisierung von Performances in mehreren Märkten eingesetzt wird.

Anwendungen mit hoher Wirkung

- Kurzvideo-Ersteller: schnelle Tanzadaptionen und synchronisierte Lippenbewegungen, die kanalübergreifend skalieren.

- Markenmarketing: konsistente, lokalisierte Schauspielerleistungen ohne mehrere Studioaufnahmen.

- Filmemacher: schnelle Previsualisierung und Performance-Prototyping für Blocking und kreative Reviews.

- Bildung & Training: framegenaue Demos für Sporttechniken oder Verfahrensanweisungen.

10. Benutzerhandbuch: Maximierung Ihrer Ergebnisse

Die Resultate verbessern sich dramatisch, wenn Aufnahme- und Parameterwahl auf die Stärken des Modells abgestimmt sind; kleine Änderungen in der Aufnahmetechnik führen zu deutlich weniger Render-Wiederholungen.

Praktische Spezifikationen

- Referenzclips: 3–30 Sekunden; 24–60fps je nach Bewegungsdichte.

- Auflösung: mindestens 720p, 1080p+ für Nahaufnahmen-Fidelity.

- Zielbild: hochauflösend, neutraler Hintergrund, ähnlicher Kamerawinkel wie Referenz.

Dreh-Checkliste

- Kamera stabilisieren; Handheld-Wackler möglichst vermeiden.

- Separate Nahaufnahmen von Gesicht und Händen erfassen, wenn Details wichtig sind.

- Konsistente Beleuchtung und neutrale Kostüme für einfachere Identitätsübertragung verwenden.

Batch-Tipps

- Assets nummerieren und organisieren, asynchrone API-Jobs zur Render-Warteschlange nutzen und Farbangleichung beim Export automatisieren.

11. Preis- & ROI-Analyse

Bewegungssteuerungs-Jobs benötigen typischerweise mehr Rechenleistung als einfache Text-zu-Video-Durchläufe, aber die Gesamtkampagnenkosten sinken oft, wenn vermiedene Nachdrehs und Schnittstunden berücksichtigt werden.

Beim Pitching von Kling 2.6 für eine Kampagne sollte der Vergleich als Plattformkosten plus vermiedene Studiotage und Postproduktionsstunden dargestellt werden.

ROI-Checkliste

- Modellkosten pro Minute gegen Studio- und Talentgebühren rechnen.

- Vermeidbare Kosten hinzufügen: Reisen, Nachdrehs, Mocap-Equipment, lange Schnittzyklen.

- Kostenlose Credits für Konzeptiterationen nutzen und bezahlte Credits für finale Render reservieren.

12. FAQ: Alles, was Sie wissen müssen

Kurze, erfahrungsbasierte Antworten auf häufige Fragen zum Betrieb.

- Wie entferne ich das Wasserzeichen? Bezahlte Tarife oder Enterprise-Lizenzen entfernen Wasserzeichen in der Regel.

- Erlaubt Kling NSFW-Inhalte? Plattformrichtlinien und Filter gelten; prüfen Sie die Kontobedingungen.

- Sind Kling-Videos privat? Datenschutz hängt von Kontoeinstellungen und Export-/Speicheroptionen ab.

- Unterstützte Bewegungsreferenzdauer? 3–30 Sekunden sind ein praktischer Bereich für robuste Extraktion.

- Mehrere Charaktere? Unterstützt mit sorgfältigen Multi-Subjekt-Referenzen und zusätzlichen Tokens.

- Eigene Voiceovers? Hochladen eigener Audios ist möglich; integrierte Audiofunktion erzeugt synchronisierte Stimme und Effekte.

13. Fazit & Einstieg — Zusammenfassung

Kling 2.6 stellt einen praktischen und sofortigen Produktivitätssprung dar: Es verwandelt referenzgesteuerte Bewegung in ein wiederholbares Produktionstool und kombiniert diese Bewegung mit synchronisiertem Audio in einem einzigen Durchgang, was die Zeit von der Idee bis zum veröffentlichbaren Clip verkürzt.

Stärken sind Bewegungsgenauigkeit, integriertes Audio und vorhersehbare Iterationen; Einschränkungen bestehen bei extremer Stilistik und stark verdeckten Referenzen, wo traditionelle Mocap- oder kontrollierte Studioaufnahmen weiterhin Vorteile bieten.

Drei-Schritte-Schnellstart

- Einen 5–12 Sekunden sauberen Referenzclip drehen (Einzelaufnahme, stabile Rahmung).

- Ein hochwertiges Zielbild vorbereiten, das Rahmung und Beleuchtung entspricht.

- Einen konservativen Test mit Basis-Tokens durchführen, dann Mikrotokens für Details hinzufügen.

Behauptungen zur Bewegungssteuerungs-Architektur von Kling und den nativen Audiomöglichkeiten basieren auf Modelldokumentation, API-Referenzen und praktischen Tests von Kling VIDEO 2.6 Motion Control sowie verwandten Kling-Veröffentlichungen.

Empfohlene Beiträge